はじめに:AIが騙される時代がやってきた

スマートフォンで質問を入力すると、まるで人間のように答えてくれる生成AI。ChatGPTやGeminiなど、私たちの生活に身近になったこれらのツールですが、実は大きな落とし穴があることをご存知でしょうか。

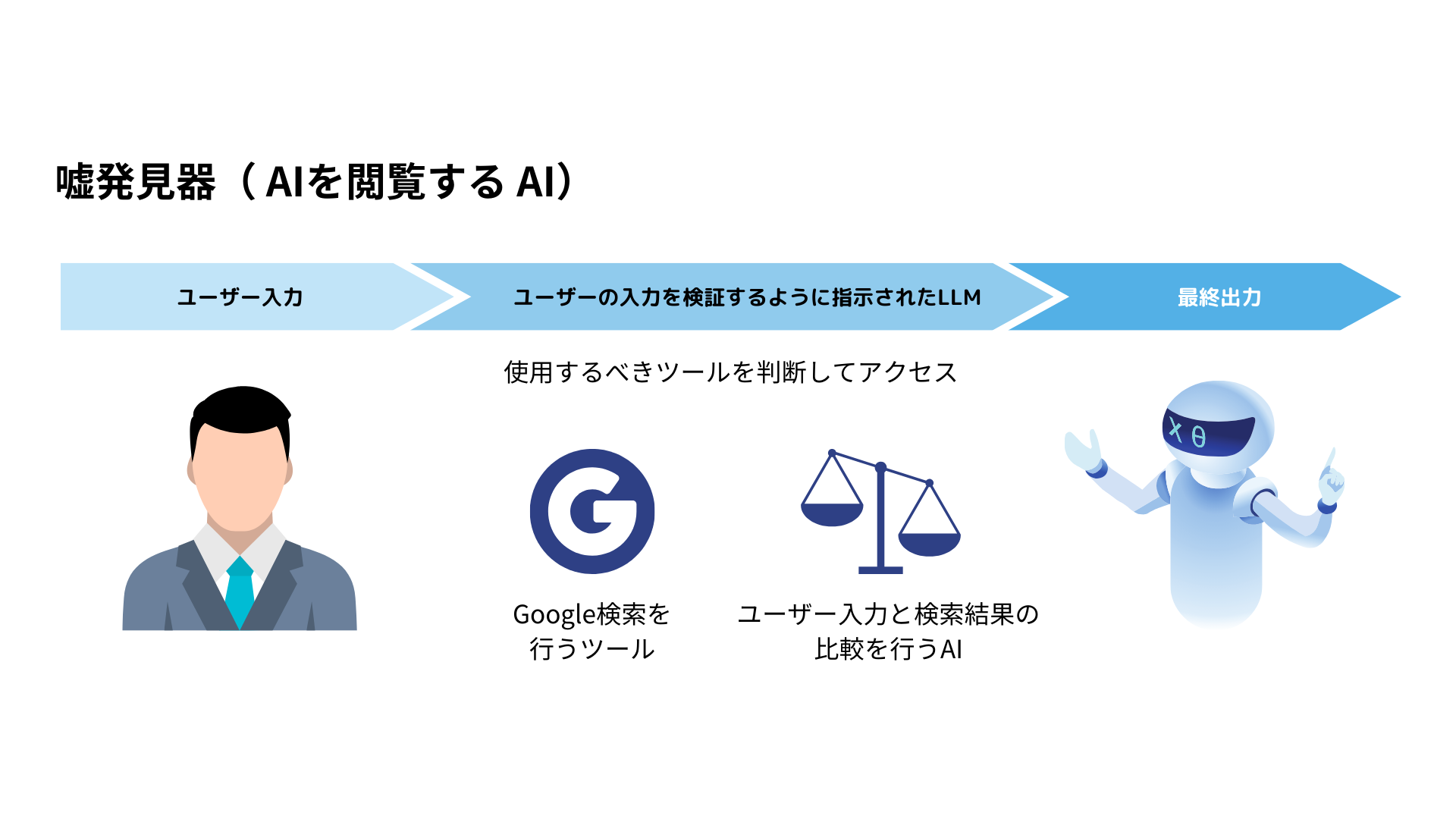

それは「ハルシネーション」と呼ばれる現象です。AIが事実ではない情報を、まるで本当のことのように自信満々に答えてしまう問題のことです。この記事では、なぜAIが嘘をつくのか、どのような危険があるのか、そしてどう対処すべきかを詳しく解説していきます。

ハルシネーションとは何か?

「ハルシネーション」とは、もともと医学用語で「幻覚」を意味する言葉です。人間が実際には存在しないものを見たり聞いたりする現象を指します。AIの世界では、これになぞらえて「AIが事実に基づかない虚偽の情報を、まるで真実であるかのように生成してしまう現象」をハルシネーションと呼んでいます。

AIが「嘘」をつく理由

想像してみてください。あなたが友達から「昨日のテストの答え、覚えてる?」と聞かれたとき、本当は覚えていないのに、なんとなくそれらしい答えを言ってしまったことはありませんか?AIのハルシネーションも、これと似ています。

AIは「何かしら答えを返さなければならない」と思い込んでいるため、正確な答えを知らない場合でも、学習したデータの断片を組み合わせて、それらしい答えを作り出してしまうのです。

実際に起きた深刻な事例

弁護士の虚偽判例事件

アメリカで実際に起きた事件です。ニューヨーク州のスティーブン・シュワルツとピーター・ロドゥカという弁護士が、ChatGPTを使って法廷で使う判例を調べました。ChatGPTは6つの判例を提示しましたが、後になってその全てが存在しない架空の判例だったことが判明しました。ChatGPTに法律文書を書かせた弁護士、ウソついて罰金 – Gizmodo

結果として、この弁護士と法律事務所は裁判所から5,000ドル(約72万円)の罰金を科されました。これは、AIのハルシネーションが現実の法廷で問題となった象徴的な事例です。ChatGPTがでっちあげた存在しない過去の判例をそのまま採用した弁護士に5000ドルの支払いが命じられる

重要なポイント

この事件は、専門職であっても、AIの情報をそのまま信用することの危険性を示しています。法律のプロでさえ、AIの生成した虚偽情報に騙されてしまったのです。

ラジオ司会者への名誉毀損

もう一つの深刻な事例として、ラジオ番組の司会者マーク・ウォルターズ氏に関する件があります。ChatGPTが「ウォルターズがセカンド・アメンドメント財団から資金をだまし取り、不法に自分のものにした」として、財団の設立者が告訴したとする虚偽の訴訟をでっちあげました。ChatGPTが告訴状を「偽造」 米男性、名誉毀損でオープンAI提訴 – Forbes JAPAN

この事件は、ハルシネーションが個人の名誉や信用を著しく傷つける可能性があることを示しています。ウォルターズ氏はこの件でオープンAIを名誉毀損で提訴しています。

ハルシネーションの種類と特徴

ハルシネーションには、いくつかの種類があります。それぞれの特徴を理解することで、より効果的に対処できるようになります。

事実ハルシネーション

実際には存在しない事実をAIが作り出してしまう現象です。例えば、存在しない歴史上の人物について詳しく説明したり、起こったことのない出来事を事実として語ったりします。

文脈ハルシネーション

質問の文脈を正しく理解できず、関係のない情報を答えとして提示してしまう現象です。これは、AIが質問の意図を誤解することで起こります。

構造ハルシネーション

正しい内容であっても、求められている形式や構造で答えられない現象です。

創造的ハルシネーション

AIが完全に新しい概念や理論を「発明」してしまう現象です。これは最も危険な型の一つで、一見すると革新的に見えるため、騙されやすいという特徴があります。

なぜハルシネーションが起こるのか?

学習データの問題

AIは、インターネット上の膨大な文章データを学習しています。しかし、インターネット上の情報には正しいものもあれば、間違ったものもあります。小説やフィクション、冗談、さらには意図的な偽情報まで含まれています。

AIは、これらの情報を「事実」と「フィクション」に区別することができません。すべてを同じように学習してしまうため、間違った情報も「正しい情報」として記憶してしまうのです。

AIの仕組み上の限界

現在の生成AIは、「次にどの単語が来るか」を予測することで文章を作っています。これは、文章の流れや文法は上手に作れますが、内容の正確性は保証されません。

例:「日本で一番高い山は」という文章に続く単語として「富士山」が来る確率が高いことは学習していますが、本当に富士山が日本一高い山なのかという事実確認はしていないのです。

情報の古さ

AIの学習データには「学習の期限」があります。例えば、ChatGPTの場合、無料版は2021年9月までの情報しか知りません。ChatGPTの学習データはいつまで?無料版でも最新情報を取得する方法 – Goat Man それ以降に起きた出来事については、推測で答えるしかないため、間違った情報を生成してしまいます。

「答えなければならない」というプレッシャー

人間であれば「わからない」と素直に答えることができますが、AIは常に何かしらの答えを返そうとします。知らない情報について聞かれても、学習した情報の断片を組み合わせて、それらしい答えを作り出してしまうのです。

実際の検証:AIのハルシネーション例

実際にChatGPTに質問して、どのような間違いをするかを見てみましょう。

地理に関する質問での間違い

「日本で2番目に大きな湖は?」という質問に対して、ChatGPTは時々「サロマ湖」と答えることがあります。しかし、実際には日本で2番目に大きな湖は「霞ヶ浦」(168.19平方キロメートル)で、サロマ湖(151.63平方キロメートル)は3番目です。日本の「大きな湖」面積ランキングTOP20! 1位の琵琶湖に次ぐ2位は? – ITmedia

歴史上の人物での間違い

戦国武将の加藤清正について質問したところ、正しい情報(1562年生まれ、愛知県名古屋市出身)を答える場合もあれば、間違った情報(1563年生まれ、長崎県出身など)を答える場合もあります。加藤清正 – Wikipedia このように、同じ質問に対しても一貫性のない回答をすることがあります。

架空の出来事への詳細な回答

存在しない「御所浦の戦い」について質問したところ、AIは詳細な戦いの経緯、参戦した武将、戦場の場所まで具体的に説明することがあります。これは典型的な事実ハルシネーションの例です。

日本政府の見解と対策

総務省が発行した「令和6年版 情報通信白書」では、生成AIの課題として明確にハルシネーションを挙げています。同白書では以下のように述べています:令和6年版 情報通信白書|生成AIが抱える課題 – 総務省

「生成AIは事実に基づかない誤った情報をもっともらしく生成することがあり、これをハルシネーション(幻覚)と呼ぶ。技術的な対策が検討されているものの完全に抑制できるものではないため、生成AIを活用する際には、ハルシネーションが起こる可能性を念頭に置き、検索を併用するなど、ユーザーは生成AIの出力した答えが正しいかどうかを確認することが望ましい。」

これは、国として生成AIの利便性を認めつつも、その危険性について十分な注意を促していることを示しています。

ハルシネーションを見抜く方法

1. 複数の情報源で確認する

AIから得た情報は、必ず他の信頼できる情報源で確認しましょう。特に以下のような情報源が有効です:

- 政府機関のウェブサイト:統計情報や法律、制度について

- 新聞社のウェブサイト:最新のニュースや事件について

- 学術論文:専門的な知識について

- 企業の公式サイト:その企業に関する情報について

2. 常識的な判断を働かせる

AIの回答が常識的に見て不自然でないかを確認しましょう。例えば:

- 日付や年代が矛盾していないか

- 人物の年齢と活動時期が合っているか

- 地理的な情報が正確か

3. 詳細すぎる情報に注意する

実際には曖昧な情報について、AIが異常に詳細に答える場合は要注意です。本当に正確な情報であれば、そこまで細かいデータが残っていることは稀だからです。

4. AIに根拠を聞いてみる

「その情報の出典は何ですか?」「どこでその情報を知りましたか?」と聞いてみましょう。ただし、AIは根拠についても嘘をつく可能性があるため、最終的には自分で確認することが重要です。

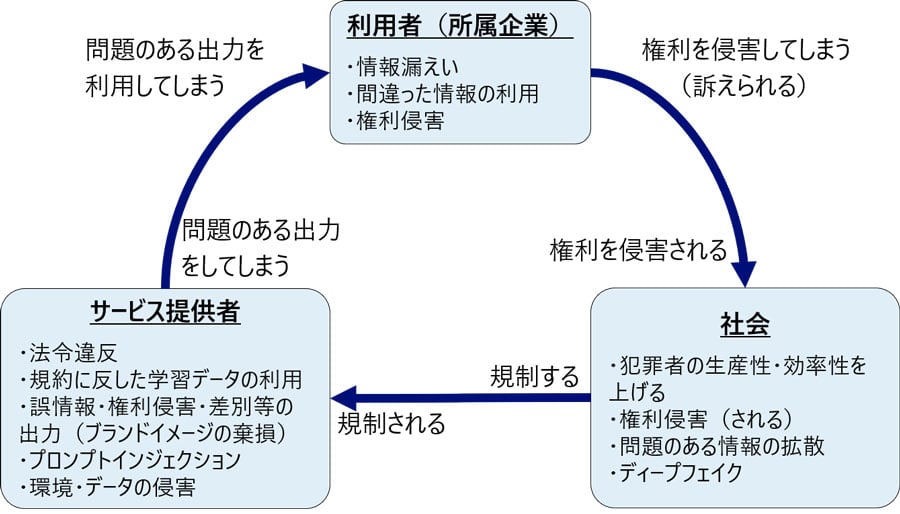

効果的な対策方法

個人レベルでの対策

- ファクトチェックの習慣化

AIから得た情報は必ず複数の信頼できる情報源で確認する習慣をつけましょう。 - 重要な判断にはAIを使わない

医療、法律、金融など、重要な判断が必要な分野では、AIの情報だけに頼らず、必ず専門家に相談しましょう。 - AIの限界を理解する

AIは「完璧な存在」ではなく、「便利だが間違いも多いツール」として捉えることが大切です。

学校や職場での対策

- AIリテラシー教育の実施

AIの仕組みや限界について正しく理解するための教育を行います。 - ガイドラインの策定

AI使用に関する明確なルールを作り、適切な使用方法を周知します。 - チェック体制の構築

AIを使用した作業については、必ず人間による確認工程を設けます。

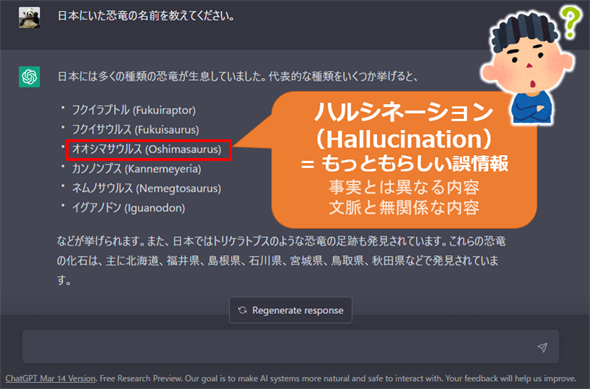

技術的な対策の現状

RLHF(人間のフィードバックからの強化学習)

現在、多くのAI開発会社が採用している技術です。人間が「良い回答」と「悪い回答」を判定し、AIがより適切な回答をするように学習させる方法です。

グラウンディング

AIが答える際に、特定の信頼できる情報源だけを参照するように制限する技術です。これにより、学習データに含まれる不正確な情報の影響を軽減できます。

検証システムの開発

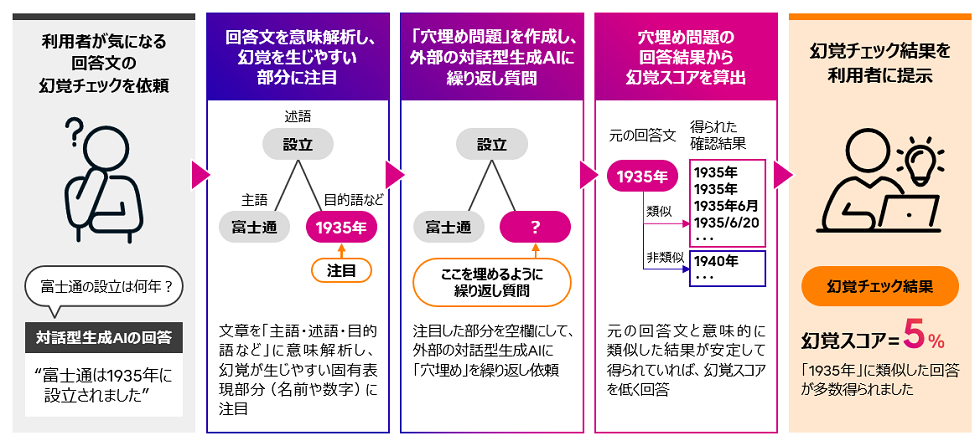

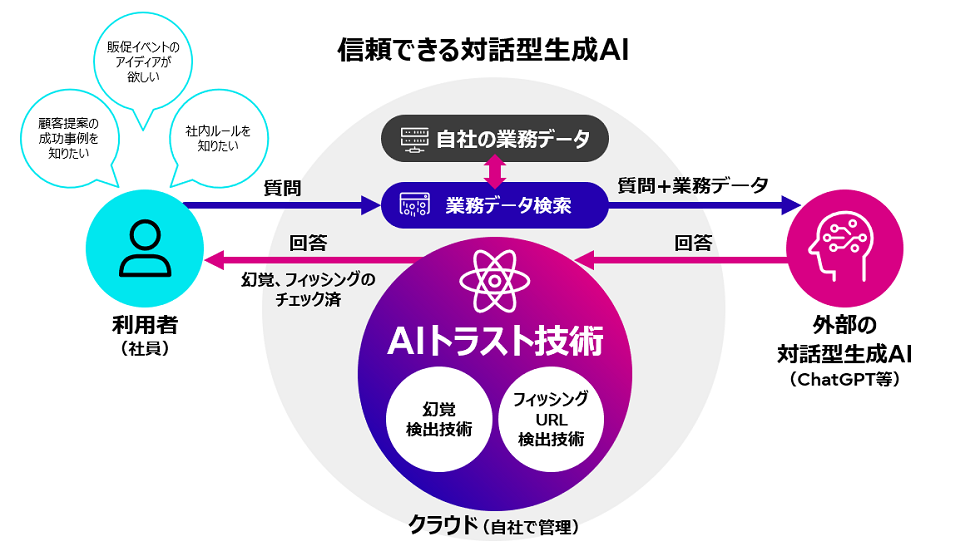

富士通では、2023年9月に対話型生成AIから出力される回答の信頼性を向上させるハルシネーション検出技術を開発し、提供を開始しています。対話型生成AIの幻覚やAIを騙す敵対的攻撃に対処できるAIトラスト技術を開発 – 富士通 この技術により、AIの回答の正確性を自動的にチェックすることが可能になりました。

ハルシネーションと向き合う未来

完全な解決は困難

専門家の間では、ハルシネーションを完全に解決することは技術的に非常に困難だとされています。なぜなら、AIの「創造性」と「正確性」はトレードオフの関係にあるからです。

創造的な文章を書いたり、新しいアイデアを提案したりするためには、ある程度の「想像力」が必要です。しかし、この想像力が時として事実とは異なる内容を生み出してしまうのです。

私たちの対応が重要

技術的な解決が困難である以上、重要なのは私たち利用者の対応です。AIを「万能の回答者」として盲信するのではなく、「優秀だが間違いもする助手」として適切に活用することが求められています。

教育の重要性

特に重要なのは、次世代を担う若い人たちへの教育です。AIネイティブ世代と呼ばれる現在の中高生には、AIの便利さと同時に、その限界や危険性についても正しく理解してもらう必要があります。

結論:賢くAIと付き合うために

生成AIのハルシネーション問題は、技術の進歩に伴って生まれた新しい課題です。しかし、この問題を恐れてAIの利用を完全に避ける必要はありません。重要なのは、適切な知識を持って賢く付き合うことです。

以下のポイントを心がけることで、AIを安全かつ効果的に活用できます:

| ポイント | 具体的な行動 |

|---|---|

| 疑う習慣を持つ | AIの回答を鵜呑みにせず、常に批判的に検討する |

| 確認を怠らない | 重要な情報は必ず複数の信頼できる情報源で確認する |

| 限界を理解する | AIは完璧ではないことを常に念頭に置く |

| 適切な場面で使う | 重要な判断には専門家の意見を求める |

AIは私たちの生活を豊かにする素晴らしいツールです。しかし、その力を最大限に活用するためには、私たち自身が賢く、注意深く利用する必要があります。ハルシネーション問題を正しく理解し、適切に対処することで、AIとより良い関係を築いていきましょう。

この記事が、皆さんがAIを安全に活用するための一助となれば幸いです。技術は日々進歩していますが、それを使いこなすのは私たち人間の責任なのです。

参考文献・出典

- 総務省「令和6年版 情報通信白書|生成AIが抱える課題」

- WEEL「生成AIのハルシネーションとは?種類や事例、発生の原因と対策方法を解説」

- NRIセキュア「生成AIのリスクを整理する|3つの観点でリスクと対策を解説」

- IT Leaders – インプレス「富士通、生成AIの回答誤りを検出する技術を開発」

- Gizmodo「ChatGPTに法律文書を書かせた弁護士、ウソついて罰金」

- Forbes JAPAN「ChatGPTが告訴状を『偽造』 米男性、名誉毀損でオープンAI提訴」

- ITmedia「日本の『大きな湖』面積ランキングTOP20! 1位の琵琶湖に次ぐ2位は?」

AI EBISU

AI EBISU